大规模光电混合集成:数据中心新范式|Mo@EE Times

发布时间:2023-09-08

去年以来,以ChatGPT为代表的大型语言模型热席卷全球,随即引发了各大科技公司竞逐AI赛道,引爆了“百模大战”。AI热背后,是算力需求的激增。面对这一局面,半导体行业该如何见招拆招,提供高通量、低延迟、低能耗的计算硬件和算力解决方案,为大语言模型发展解开算力限制?

近日,曦智科技工程副总裁Maurice Steinman(Mo)为知名电子工业杂志EE Times(电子工程专辑)撰文,对数据中心如何应对算力需求激增的挑战,发表了他的看法。

Maurice Steinman Mo

以下为文章全文:

在自动驾驶、大语言模型(LLMs)等颠覆性AI应用的助推下,半导体行业来到了又一个转折点。一时间,好像所有人都在谈论OpenAI的ChatGPT,这个“聊天机器人”的复杂程度看起来已经跨过了对话能力的门槛。这项技术应用于各行各业的潜力充满无限可能。

如此级别的人工智能需要从数据中分析和提取信息,强大的数据存储、传输和处理需求,对现有的数据中心和边缘设备提出了挑战。据Finances Online估计,2021年至2024年的数据消费将由2021年74泽字节(zettabytes)和2022年的94泽字节,逐步增长至2023年的118泽字节和2024年的149泽字节。数字大得惊人,数据中心现有的计算能力很难跟上。

数据中心现有的大规模分布式计算系统和离散型计算系统,无法满足对计算能力持续增长的需求。

当然,工程师们一直在研发更复杂的模型来分析和使用数据,并最终提升算力。然而,提升计算能力的传统方式受限于物理定律,传统的单芯片算力路径并不可持续。加强创新越来越成为IT产业的当务之急,这就给半导体行业带来了机会。

传统计算芯片的性能提升已遇到瓶颈。自半导体产业诞生的60多年以来,算力的提升一直遵循着摩尔定律(Moore’s Law)和登纳德缩放比例定律(Dennard Scaling)。前者预测,晶体管密度每18个月翻一倍,后者则是说晶体管密度提升的同时,功耗密度保持不变。

这两大定律让芯片得以在持续提升算力的同时保持功耗和面积恒定。随着芯片制程来到5纳米甚至3纳米,晶体管密度已接近物理极限。摩尔定律正在放缓,登纳德缩放比例定律已于2004年左右失效,随着晶体管密度的提升,芯片的供能和散热遭到“功耗墙”(power wall)的挑战。先进制程的流片和设计成本,又带来了“成本墙”(cost wall)问题。传统单芯片算力提升路径已不可持续。

当然,为了提升以及更好利用算力,业界也在不断加大投入。而数据中心突破瓶颈,克服困难需要的是底层技术的革新。

现在出现了一种新的趋势——基于大规模光电集成技术的数据中心计算范式,可用于下一代数据中心的发展。其结果就是大规模光电集成电路的比重将逐渐增加,引入基于集成硅光子技术的信息处理和互连能力。

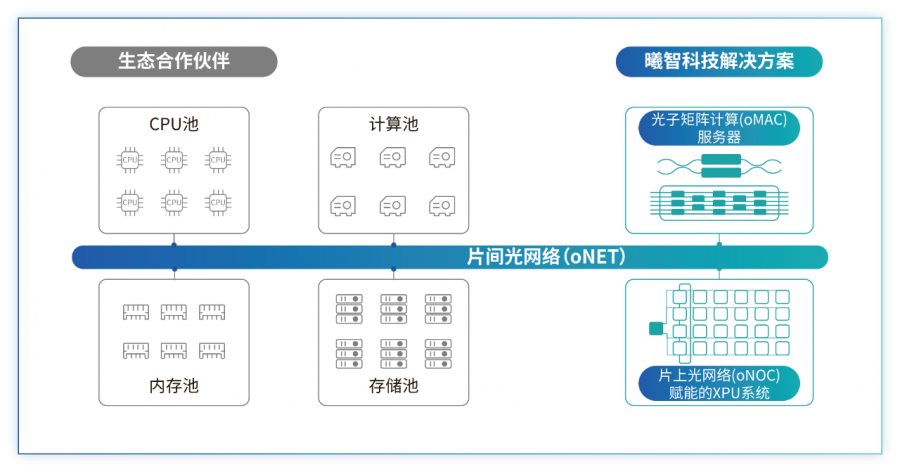

一个集成了硅光子技术的光电混合数据中心,结合了光子计算、片上光网络、片间光网络以及其他技术,纵向提高单节点计算能力(scale-up,纵向扩展),横向提升大规模分布式计算的效率(scale-out,横向扩展)。

即使摩尔定律和登纳德缩放定律仍能延续,离散型计算系统也无法实现算力的指数级增长。数据中心反而必须部署大型分布式计算系统,消耗更多资源以满足增加的算力需求。

硅光赋能的计算提供了一条超越摩尔定律的算力提升路径,晶圆级片上光网络能使计算范式得以在传统电芯片和存储芯片上高效运行,从而提高单节点计算能力。和所有新技术一样,这一全新计算范式将会需要一定的时间逐步建立起成熟的供应链、生态系统和商业模式。

从底层器件到顶端的应用软件开发,都需要进行创新。到目前为止,基于硅光子学的新计算范式的前景非常迷人,它将帮助数据中心应对所面临的挑战,直到泽字节(zettabytes)时代的结束,进入尧字节(yottabytes)时代以及更远的未来。